文章摘要 本文介绍了由AI生成的视频技术Sora以及其在不同领域的应用。作者通过展示Sora生成的不同类型的视频,并指出其中的真实性和连续性问题,来讨论Sora的表现能力。此外,文章还介绍了Sora团队的核心成员和他们的背景。• 💡 Sora在风景和动物领域的视频生成表现良好,能够模拟真实的画面细节和动作。• 💡 人物和复杂场景方面,Sora的表现尚有改进空间,存在一些逻辑和视觉效果的问题。• 💡 Sora团队融合了视觉效果和听觉效果,展示了潜在的震惊行业的创新能力。

在文章开始,请先看下面的视频:

您目前设备暂不支持播放

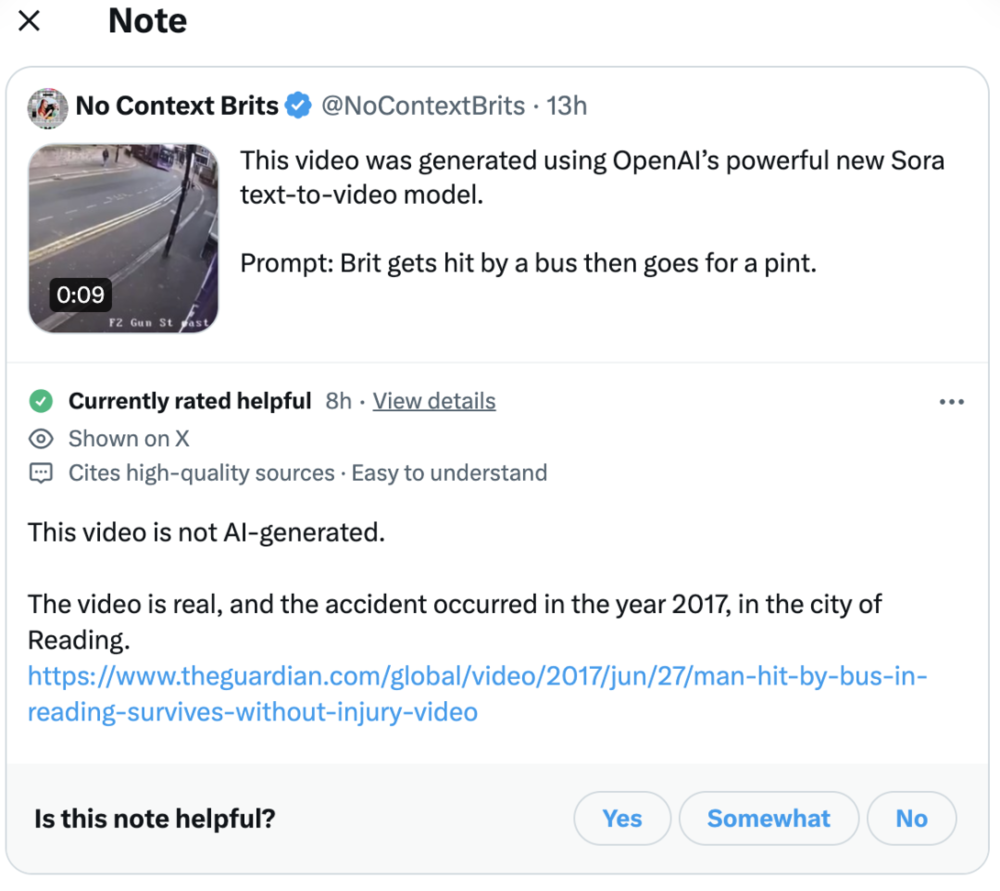

视频发布者“No Context Brits”表示这是 Sora 生成的,提示词是:Brit gets hit by a bus then goes for a pint。

那么你认为,上面视频是真的还是 AI 生成的?

这个问题的答案,我们留到最后揭晓。

一、现实真的不存在了吗?

当大家都在说 Sora 颠覆行业的时候,Sore 究竟能颠覆多少?我们由易到难,看看 Sora 制作的视频,可以达到什么级别。

1. 风景

风景类视频制作可以说是入门级,画面细节要求相对少一些,构图、运镜相对比较重要。而 Sora 确实能制作出纪录片里常用到的运镜方式,构图也是参照了构图规则的:

您目前设备暂不支持播放

同时,与视频生成领域的其他同行比,Sora 在真实性、连续性上的进步也是很明显的:

2. 动物

在 OpenAI Sora 研发成员 Aditya Ramesh 发出的一个关于一只蚂蚁“在蚁巢内部移动的视角镜头”的视频里,Sora 给出了如下效果:

您目前设备暂不支持播放

这个视频犯了基础的认知错误:里面的蚂蚁只有四条腿,真实世界里的是六条腿。杨立昆(Yann LeCun)也直接指出了这一点,但仍止不住网友对视频效果的赞叹。

题外话:Aditya 与 LeCun 也有一段缘分。据 LeCun 爆料,Aditya 本科就读于纽约大学,并参加过其实验室的一些项目。

下面这只“飞入海底的蝴蝶”,虽然没有尊重基本事实(毕竟蝴蝶没入海底怕是飞不起来),但如果是特效,那还是可以的:

一只寻找庇护所的流浪猫:

在单只动物的相对简单的场景里,Sora 表现还是不错的。

3. 人物

在最新发布的 Sora 生成视频里,有一个体现人类惊讶表情的视频,但效果不太好:鲨鱼在离沙滩特别近的沙滩出现,女人夸张的惊讶……“那个女人比鲨鱼更让我害怕,制作恐怖电影可能是 Sora 的最佳用途。”网友评价。另外,这个视频的逻辑还需要提示词输入进行调整,比如男人的无动于衷。

您目前设备暂不支持播放

下面这个老人过生日的视频应该很多人见过,效果相对还是相对丝滑一些的,虽然老人吹蜡烛时,烛光动也没动……

这个猫和主人互动的视频里,猫挠到主人鼻子时,鼻子的变化给人感觉像一张纸。另外,她不疼吗?!

更复杂一些的场景,我们看看 Sora 的一镜到底:

您目前设备暂不支持播放

“几乎完美。但是吹毛求疵,这里的视角不太好。看起来用餐的人坐在一个小型市场旁边。”有敏锐的网友指出:

“大多数人身上都发现了人工制品和某种程度的幻觉。”复杂场景下,Sora 还是做不到完美。

4. 特效

特效视频就不存在真实性问题了,视觉效果是重要的衡量因素。

Sora 研发团队 Bill Peebles 发布了一只“科技犬”视频:未来控制论德国牧羊犬的特写镜头,展示了其引人注目的棕色和黑色皮毛......

您目前设备暂不支持播放

一位数字艺术方面的从业者表示,“这看起来比我们见过的任何 CGi 都更真实。迫不及待地希望能够尽快将视频制作变为 3D 模型,这样我们就可以在游戏中拥有这些资源和动画。”也有网友调侃道,“本次拍摄中没有动物受伤。”

Bill 还发布了另一个特效视频:“一座巨大的大教堂里全是猫。放眼望去,到处都是猫。一个男人走进大教堂,向坐在王座上的巨型猫王鞠躬。”在经过网友增加旁白和配音后,便是这样的:

您目前设备暂不支持播放旁白 @ChatGPTapp

配音者 @elevenlabsio

音乐由 @suno_ai_

如果有一天,OpenAI 能够直接将视觉效果和听觉效果一起输出,那又会是震惊行业的一件大事。可以看下,网友给 Sora 视频加上视觉效果是什么样的:

您目前设备暂不支持播放

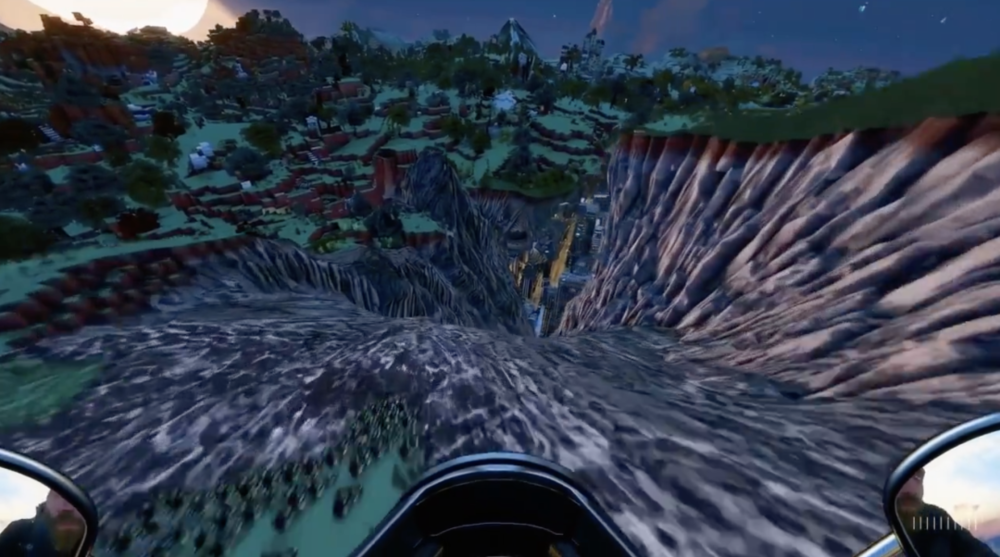

Sora 研发团队另一位重要成员 Tim Brooks 用 Sora 让沙盒游戏《我的世界》拥有了“有史以来最华丽的高分辨率 8k 纹理包”:

同时,Tim 还让《我的世界》视频融合进摩托车视角,“这个功能有如此大的创造潜力”Tim 说道。

其实效果已经不错,有网友建议可以在提示中加上“光线追踪、光晕、后期特效”等,这样效果可能会更好。

下面是一个 Sora 改变视频的风格和环境的例子,一辆跑车穿梭在水底、恐龙乐园、像素世界等等场景中:

您目前设备暂不支持播放

“一只鸭子走在波士顿的街道”,如果更加复杂一些,会不会有漫威的感觉?

“在叶子上行驶的火车”,叶子的脉络还真是很清晰的,当然也有网友认为这种视频没有什么用,更多是一种数字垃圾。

二、谢赛宁:Sora 跟我没关系

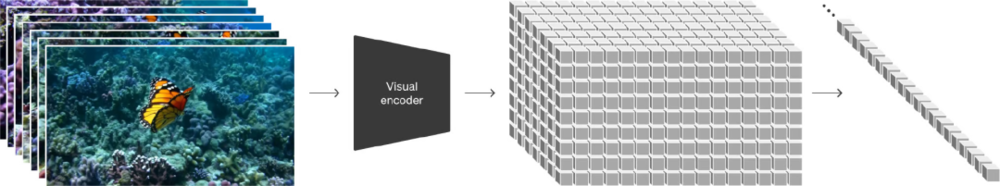

Sora 能有上面的效果,主要得益于 DiT 架构和 Spacetime Patch。

其中,Spacetime Patch 建立在 GoogleDeepMind 对 NaViT(原生分辨率视觉 Transformer)和 ViT(视觉 Transformer)的早期研究基础上。Patch 可以理解为 Sora 的基本单元,类比 Token。Sora 处理一系列的 Patch,并预测出序列中的下一个 Patch。

Sora 团队发现补丁是一种高度可扩展且有效的表示形式,因此通过 Spacetime Patch 将视频视为补丁序列,捕捉视觉数据使模型能够从更准确的表达中学习。

从 OpenAI 的技术报告可知,Sora 的作者团队有 13 位成员,如今被报道最多的核心成员包括研发负责人 Tim Brooks、William Peebles、系统负责人 Connor Holmes 等。

其中,Tim Brooks 是 DALL-E 3 作者之一,GitHub 5.7k️星项目 InstructPix2Pix 作者,博士毕业于 UC Berkeley 的伯克利人工智能研究所 BAIR。Tim 曾在谷歌为 Pixel 手机摄像头提供 AI 算法,也在英伟达负责过视频生成模型的研究。

William Peebles 也来自 UC Berkeley,去年(2023 年)刚刚获得博士学位。据悉,William 和谢赛宁合作,研发了 DiT。也因为这个关系,毕业于上海交大的天才少年谢赛宁被报道为是 Sora 的研发者之一。谢赛宁本人对此强烈否认:“一点关系都没有”。

Connor Holmes 则曾在 Colorado School of Mines、微软工作过,在 LLM、BE RT 风格的编码器、RNN 和 UNets 方面有丰富经验。“我期待解决在扩展深度学习工作负载以进行推理和训练时系统效率低下的问题。”他在自己的领英上说道。此外,Sora 团队的不少成员都是 DALL-E 3 的作者,包括两位华人 Li Jing 和 Yufei Guo。

三、结束语

“如何加入红队?我可以帮助测试”有积极参与的人,也有不喜欢生成视频的人:“我看视频,不是想看虚拟的世界,而是想通过镜头去看自己不了解的真实的世界。”

现在网上也出现了很多声称是 Sora 生成的视频,但其实并不是。比如下面这个女团视频声称是Sora生成的,但真实性存疑。

还比如下面视频的发布者“víty”表示这个“女生吃面包时与他人发生争执”视频是 Sora 生成的,提示词是:White woman eats bread, ant bitchslap, white woman laughts, pian oduhh, house eviction, cool bassout romusic.

但有网友指出,这个视频并非 Sora 生成的,而是来源于一部名为《Ti Ti Ti》的肥皂剧。看过这部剧的朋友可以出来说说~

回到文章最初问到的问题,其实帖子下面也引起了网友的各种讨论,有人说是真的,有人说是生成的。而真正的答案就是:那是真实的视频。

出自外媒 The Guardian 在 2017 年的报道。

你猜对了吗?

参考链接:

https://twitter.com/minchoi/status/1758831971726225591

https://twitter.com/NoContextBrits/status/1759212202853040265

https://openai.com/research/video-generation-models-as-world-simulators

本内容为作者独立观点,不代表虎嗅立场。未经允许不得转载,授权事宜请联系 [email protected]如对本稿件有异议或投诉,请联系[email protected]