DeepSeek-V3 是一款高性能的开源 AI 模型,支持自然语言处理、智能对话生成等任务。其 API 接口与 OpenAI 完全兼容,用户可以通过简单的配置迁移现有项目,同时享受更低的成本和更高的性能。本文档将详细介绍如何快速接入 DeepSeek-V3 API

二、注册与API Key获取1.注册 DeepSeek 账号

访问 DeepSeek 官网https://platform.deepseek.com/api_keys ,注册账号

2. 创建API key

进入下图页面创建key(注:点击创建后会出现API key,记住只出现一次,保存好。同时将 API Key 存储在安全位置,如环境变量或配置文件中)

二、使用Python调用 API(多轮对话)

二、使用Python调用 API(多轮对话)

1. 安装 OpenAI API 库:pip install openai ,或者直接在pycharm里面安装openai库

/chat/completions

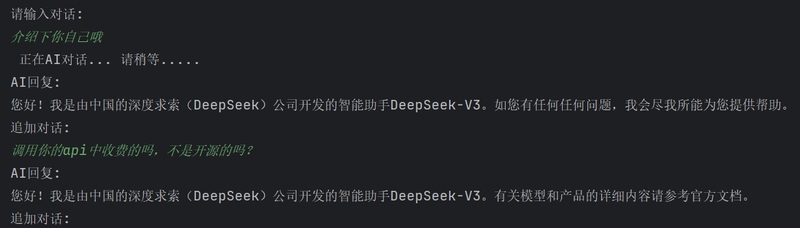

# 初始化 OpenAI 客户端 from openai import OpenAI text = input("请输入对话:\n") print(" 正在AI对话... 请稍等.....") # 请替换为你的 API 密钥 client = OpenAI(api_key="sk-xx", base_url="https://api.deepseek.com") messages = [{"role": "user", "content": text}] # 使用 stream=True 来逐行获取响应 response = client.chat.completions.create( model="deepseek-chat", # 请确保模型名称正确 messages=messages, stream=True # 启用流式响应 ) # 逐行显示响应内容 print("AI回复:") for chunk in response: if chunk.choices[0].delta.content: # 检查是否有内容 print(chunk.choices[0].delta.content, end="", flush=True) # 逐行显示 print() # 换行 while True: text = input("追加对话:\n") messages.append({"role": "user", "content": text}) response = client.chat.completions.create( model="deepseek-chat", messages=messages, stream=True ) # 逐行显示响应内容 print("AI回复:") for chunk in response: if chunk.choices[0].delta.content: # 检查是否有内容 print(chunk.choices[0].delta.content, end="", flush=True) # 逐行显示 print() # 换行三、运行效果图

四、常见问题与解答

四、常见问题与解答

1. DeepSeek-V3 与 OpenAI 的区别是什么?

DeepSeek-V3 提供与 OpenAI 相同的 API 格式,但成本更低、性能更高,同时支持自定义模型和扩展能力。

2. 如何启用流式输出?

streamtrue

3. 是否支持团队协作?

DeepSeek 支持多用户管理和 API Key 权限分配,适合团队项目。