近期deepseek继开源V3、R1大模型之后,又开源了Janus-Pro多模态支持,而且还支持app版本、网页版对话。

在春节期间更是掀起了一波国产AI的浪潮。

但如何更加经济实惠的本地化部署及使用相关大模型,已经有很多文章介绍过了。

今天提供一个更加便捷的新选择,腾讯云HAI及TI平台目前已经支持deepseek的R1及V3模型,并且支持从1.5B到70B的参数选项。

这篇文章就将介绍下如何快速在HAI平台快速部署deepseek模型

deepseek模型快速部署指南

HAI访问地址如下,目前支持免费部署体验:

网址:cloud.tencent.com/product/hai

授权及新建服务

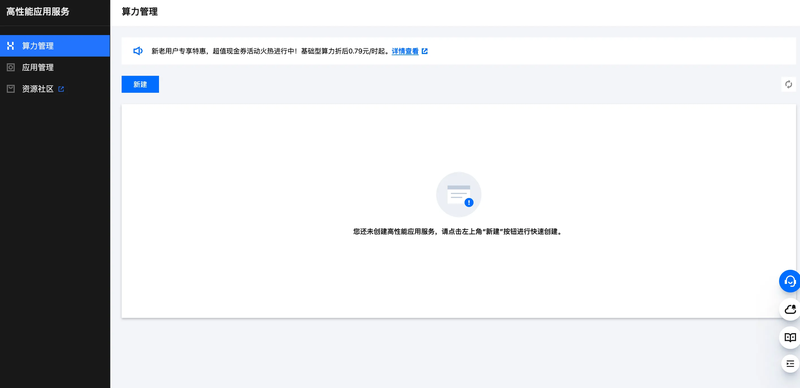

第一次使用,需要先进行授权

如果之前已经有使用过,那么点击立即使用即可

跳转后选择新建

快速部署在线服务

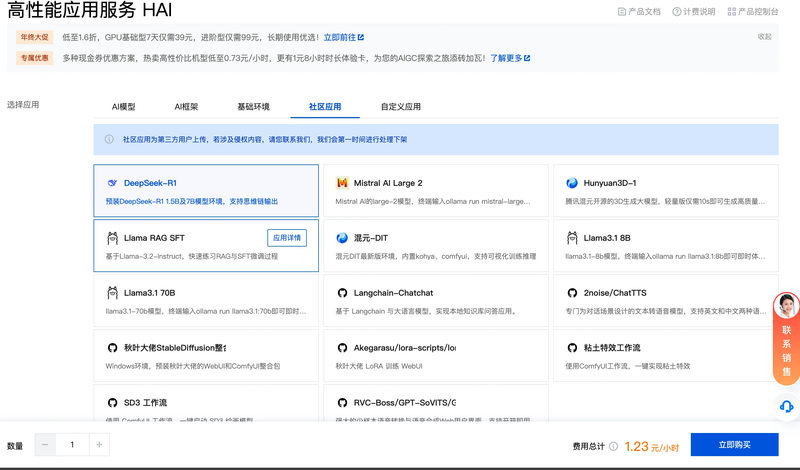

选择社区应用,然后选择deepseek-R1即可

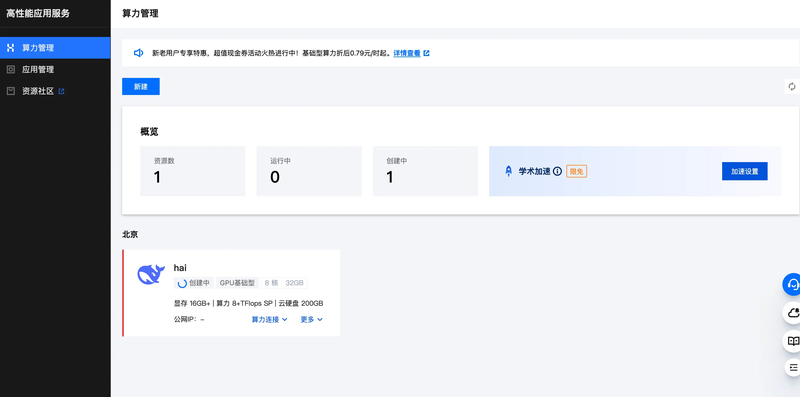

选择完成后,点击立即购买即可,然后回到控制台就可以看到服务正在创建中。

开始使用

你可以选择通过web端使用,可以通过jupytertab提供的terminal来访问,因为提供了公网ip及端口,也可以配置到一些开源的webui平台来使用。

具体如下:

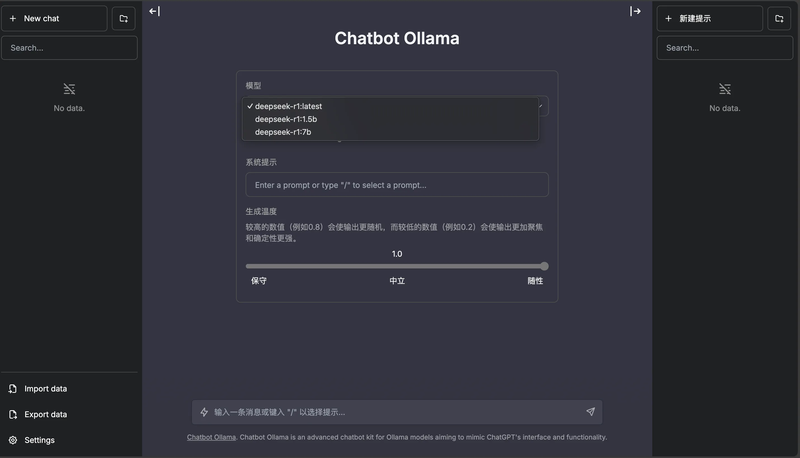

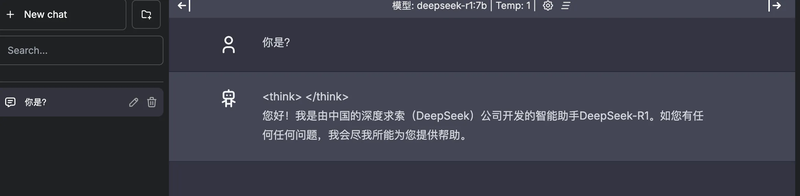

web端访问可以通过chatbotUI来访问,在「HAI」控制台选择「算力连接」->「ChatbotUI」,在新窗口中可根据页面指引操作;

试用:

终端访问方式如下:

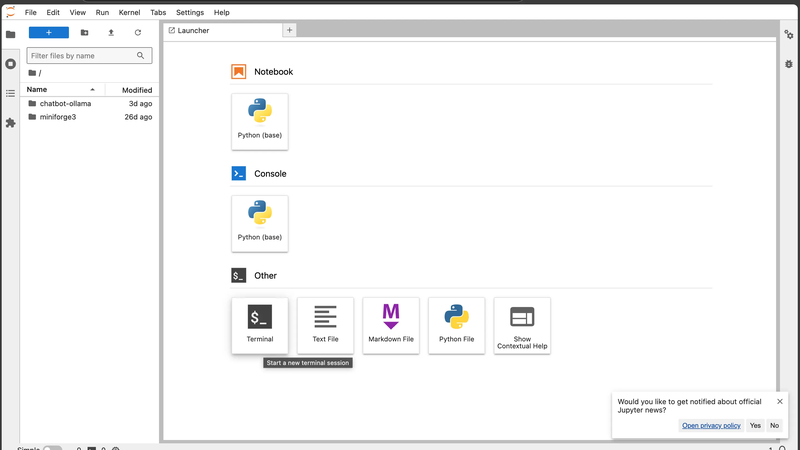

在HAI控制台选择算力连接->JupyterLab,新建一个Terminal

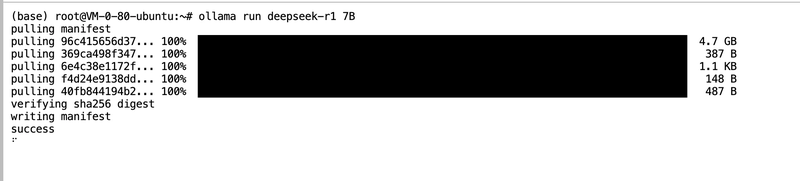

输入「ollama run deepseek-r1」命令加载默认的1.5b模型。

如果1.5B模型无法满足需求,可在命令行后输入7B/8B/14B等参数指令,自由切换至对应规格的模型。

其它

目前deepseek的优势在于价格低廉

但是部分场景的使用,需要私有化的部署。

这种情况下,如果自行去购买算力卡、配置网络、下载模型等费时费力

可以选择HAI平台来快速体验及提供线上服务。